Bei der Arbeit mit einem Codesystem stellt sich früher oder später die Frage nach der Intersubjektivität. Inwieweit weisen zwei Personen, die in ein Codesystem eingeführt wurden und dieselben Codedefinitionen vorliegen haben, den zu codierenden Elementen die gleichen Codes zu? Diese wichtige Frage stellten auch wir uns im Prozess der Annotation.

Eine gängige Vorgehensweise, um zu überprüfen, ob ein Annotations- oder Codesystem zu den gleichen Ergebnissen führt, wenn es von verschiedenen Codierenden verwendet wird, ist die Prüfung der Intercoder-Übereinstimmung.

„Mit ihrer Hilfe lassen sich Probleme mit einzelnen Kategorien und ihren Definitionen identifizieren und reduzieren, man kommt Abgrenzungsproblemen von Kategorien auf die Spur und kann zudem Codierende identifizieren, deren Vorgehen von den anderen systematisch abweicht. Somit kann die Übereinstimmungsanalyse gleichermaßen Mittel zur Überprüfung, Sicherung und Verbesserung der Qualität von Codierprozessen sein.“ (Rädiker & Kuckartz, 2019, S. 288)

Auswahl der Dokumente:

Bevor wir mit der Überprüfung der Intercoder-Übereinstimmung beginnen konnten, mussten wir bestimmen, wie viele und welche Dokumente – in unserem Fall Screenshots – für die Überprüfung genutzt werden sollten. Aus den knapp 500 Screenshots der 50 in MAXQDA annotierten digitalen Ausstellungen wurden hierfür jeweils zwei zufällig ausgewählte Screenshots pro Kategorie ausgewählt.

Das bedeutet, dass jeweils zwei Screenshots aus den klassischen Webseiten, den Scrollytelling-Ausstellungen, den virtuellen Ausstellungsräumen, den Video- und Audio-Ausstellungen sowie der Kategorie ‚Spiele und experimentelle Formen‘ – insgesamt also 10 Screenshots – vorlagen.

Vorgehen:

Codiert wurde in unserem Projekt von zwei Personen. Die erste Person war für die Annotation der gesamten 50 Ausstellungen des Korpus zuständig (Hauptcodierer:in). Eine zweite Person annotierte mit Hilfe der Codedefinitionen aus dem Annotationssystem die 10 Screenshots, die zur Überprüfung der Intercoder-Übereinstimmung ausgewählt wurden (Zweitcodierer:in). Auf dieser Grundlage wurde die Übereinstimmungsanalyse durchgeführt.

Die Intercoder-Übereinstimmung wurde zu einem Zeitpunkt überprüft, zu welchem der/die Hauptcodierer:in mit der Annotation der Screenshots in MAXQDA schon weit fortgeschritten war und das Annotationssystem bereits mehrfach an die Anforderungen digitaler Ausstellungen sowie speziell an die Anforderungen der Ausstellungen im Korpus angepasst wurde. So konnten bereits zu Beginn des Annotationsprozesses leicht erkennbare Probleme diskutiert und Anpassungen am Annotationssystem vorgenommen werden. Zu einem früheren Zeitpunkt wäre die Aussagekraft der Übereinstimmungsanalyse weniger hoch gewesen.

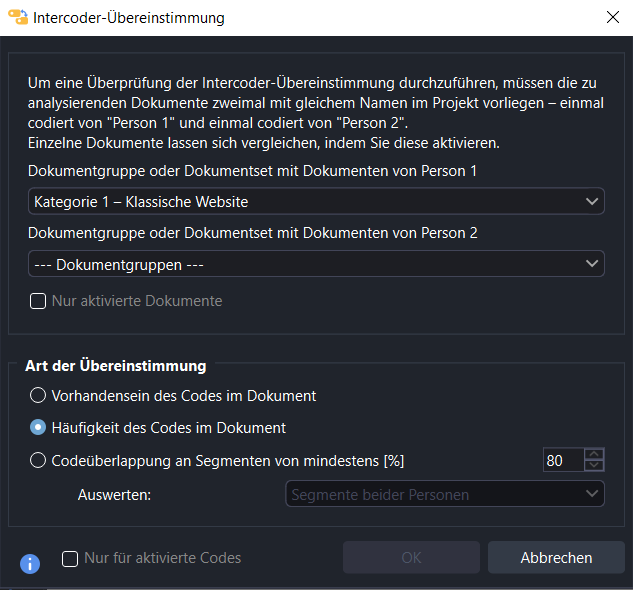

Die Text- und Datenanalyse-Software MAXQDA bietet die Überprüfung von drei verschiedenen Arten der Übereinstimmung an:

- Vorhandensein des Codes im Dokument

- Häufigkeit des Codes im Dokument

- Codeüberlappung an Segmenten von mindestens [%] (erfordert Einstellung des gewünschten Prozentwerts)

Wir haben uns entschieden wie folgt bei der Prüfung der Übereinstimmung vorzugehen:

- Bei den 10 ausgewählten bereits vollständig annotierten Screenshots wurden die bereits codierten Segmente von dem/der Hauptcodierer:in mit „leeren“ Markierungen ersetzt – die zu codierenden Segmente waren also vorgegeben.

- Die zweite Person hat diese „leeren“ Markierungen entsprechend der eigenen Einschätzung mit Codes des Annotationssystems belegt.

- Als zu überprüfende Art der Intercoder-Übereinstimmung haben wir uns für „Codeüberlappung an Segmenten“ entschieden.

Durch die Vorarbeit mit dem Markieren der Segmente durch den/die Hauptcodierer:in wird zwar auf das Codierverhalten des/der Zweitcodierer:in eingewirkt. Wir haben uns trotzdem dafür entschieden, da wir es in unserem Projekt mit einem sehr komplexen und vielschichtigen Annotationssystem zu tun haben und die zu annotierenden Webseiten sehr heterogen sind und sowohl von der Gestaltung der Elemente als auch deren Funktionen oft stark voneinander abweichen. Dies erschwert die Annotation und verringert insbesondere auch die Wahrscheinlichkeit, dass zwei Personen unabhängig voneinander dieselben Codes verwenden. Hohe Übereinstimmungswerte werden bei steigender Komplexität des Materials und des Codesystems schwerer erreichbar. Mehr Informationen dazu gibt es auf der Webseite von MAXQDA.

Ergebnis der Prüfung der Intercoder-Übereinstimmung

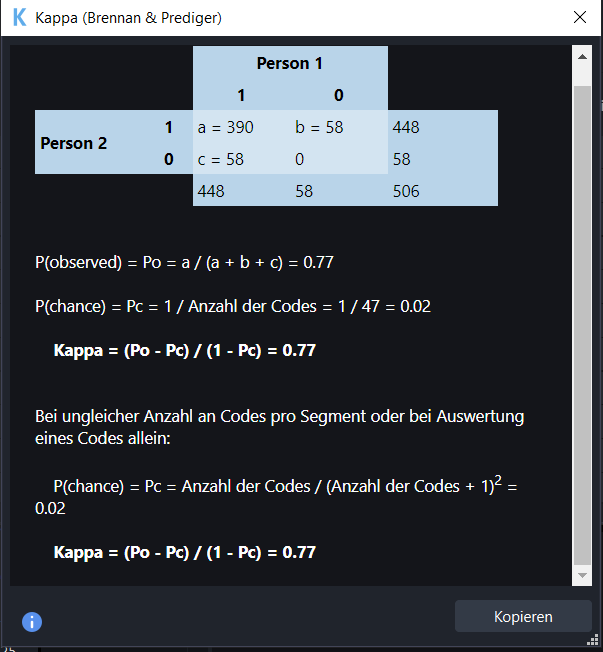

Als Vergleichswert wird bei Übereinstimmungsanalysen meist mit zufallskorrigierten Koeffizienten wie z. B. Kappa berechnet. Dafür wird die erreichte prozentuale Übereinstimmung mit der erwartbaren zufälligen Übereinstimmung verrechnet. Dieser Wert kann dann interpretiert werden. MAXQDA bietet bei der integrierten Übereinstimmungsprüfung die automatische Berechnung von Kappa nach Brennan und Prediger (1981) an.

Wir konnten bei der Prüfung der Übereinstimmung von Hauptcodierer:in und Zweitcodierer:in den Kappa-Wert 0,77 erzielen.

„Brennans und Predigers Kappa kann Werte zwischen -1,00 und +1,00 annehmen; ein Wert von 0 entspricht einem Gleichstand mit dem Zufall, ein Wert von +1 entspricht perfekter Übereinstimmung der Codierenden – weiter kann man nicht vom Zufall entfernt sein. 1,00 wird immer dann erreicht, wenn die prozentuale Übereinstimmung der beiden Codierer_innen bei 100% liegt“ (Rädiker & Kuckartz, 2019, S. 303).

Die Ergebnisse der Intercoder-Übereinstimmungsanalyse wurden im Projekt besprochen und auf häufige und auffällige Abweichungen mit Konkretisierungen in den Codedefinitionen oder durch Zusammenfügen oder Neueinführung von Codes reagiert.

Referenzen:

Rädiker, S. & Kuckartz, U. (2019). Analyse qualitativer Daten mit MAXQDA. In Springer eBooks. https://doi.org/10.1007/978-3-658-22095-2

MAXQDA. (2022, 8. Juni). MAXQDA Online-Hilfe: Intercoder-Übereinstimmung. https://www.maxqda.com/de/hilfe-mx22/teamwork/das-problem-der-intercoder-uebereinstimmung-in-der-qualitativen-forschung (zuletzt aufgerufen am 10.09.2024)

Schreibe einen Kommentar